Alors que l’IA continue de progresser, le sujet de la singularité devient de plus en plus important. Mais qu’est-ce que la singularité exactement, quand devrait-elle arriver et quels risques représente-t-elle pour l’humanité ?

Qu’est-ce que la singularité ?

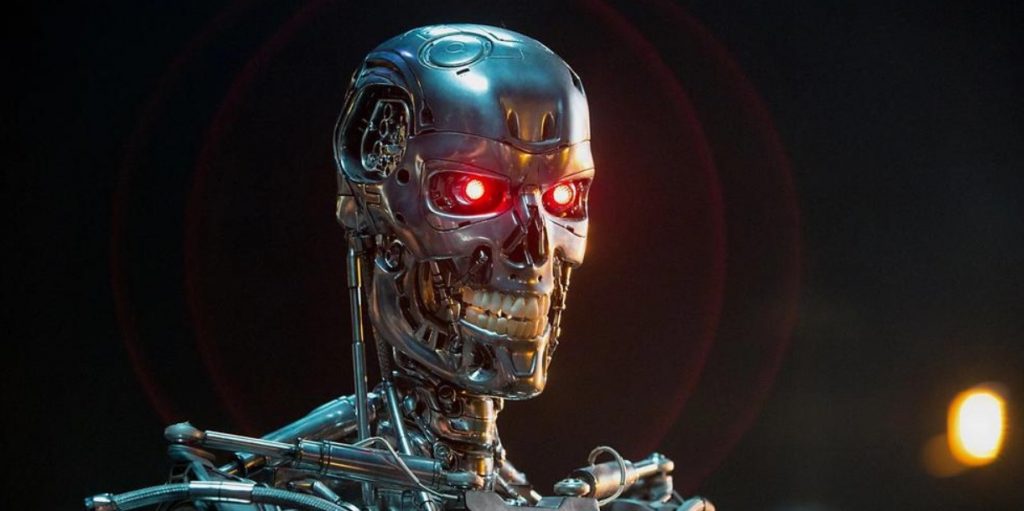

La singularité fait référence au moment théorique dans le futur où l’intelligence artificielle (IA) deviendra si avancée qu’elle dépassera l’intelligence humaine, entraînant une accélération exponentielle de la technologie et un changement radical dans la société humaine. Dans ce scénario, l’intelligence artificielle sera capable d’évoluer par elle-même sans intervention humaine.

Cela signifie que les humains ne seront plus capables de comprendre ou de contrôler la technologie en cours de création, ce qui pourrait conduire les machines à assumer un certain niveau de contrôle sur l’humanité.

Quand la singularité se produira-t-elle ?

Avec les progrès rapides réalisés récemment dans le monde de l’IA, la singularité commence à ressembler à une possibilité. La question est de savoir quand elle se produira.

Développer un système informatique capable d’égaler et de dépasser les capacités de l’esprit humain nécessite plusieurs avancées scientifiques et techniques majeures avant que cela ne devienne une réalité. Des choses comme la sensibilité, la compréhension des nuances et du contexte, savoir si ce qui est dit est vrai et interpréter les émotions, sont toutes au-delà des capacités des systèmes d’IA actuels.

Il existe donc de nombreuses prédictions divergentes concernant la singularité.

Ben Goertzel, spécialiste de l’IA et fondateur de l’entreprise SingularityNET a prédit dans une interview de 2023 pour le site Decrypt qu’il s’attend à ce que la singularité soit atteinte en moins d’une décennie.

Le futurologue et PDG de SoftBank, Masayoshi Son, estime que nous atteindrons la singularité plus tard, mais peut-être dès 2047.

Ray Kurzweil, futurologue de renommée mondiale et directeur de l’ingénierie chez Google, a prédit il y a quelques années que la singularité se produira avant 2045. C’est actuellement la prédiction la plus fiable, car elle correspond aux avancées technologiques actuelles.

A l’inverse, certains experts pensent que la singularité ne sera jamais atteinte. En fait, certains pensent que les limites de la puissance de calcul sont un facteur majeur qui nous empêchera d’atteindre la singularité. D’autres pensent que la complexité même de l’intelligence humaine constituera un obstacle majeur à cet égard.

Mais si la singularité de l’IA a été présentée comme quelque chose qui aboutira à des machines dotées d’une intelligence surhumaine, il existe également d’autres possibilités. Un niveau d’intelligence exceptionnel devra toujours être atteint par les machines, mais cette intelligence ne sera pas nécessairement une simulation de la pensée humaine. En fait, la singularité pourrait être provoquée par une machine ou un groupe de machines super intelligentes qui pensent et fonctionnent d’une manière que nous n’avons jamais vue auparavant. Tant que la singularité ne se produit pas, on ne sait pas quelle forme exacte ces systèmes intelligents prendront.

Un élément clé de ce que la singularité de l’IA apportera est une augmentation incontrôlable et exponentielle de la croissance technologique. Une fois que la technologie sera suffisamment intelligente pour apprendre et se développer par elle-même et atteindra la singularité, les progrès et l’expansion seront rapides, et cette croissance vertigineuse ne sera plus contrôlable par les humains.

Il y a donc deux facteurs en jeu ici : la technologie super-intelligente et sa croissance incontrôlée.

Cela dit, personne ne sait si la singularité se produira vraiment.

Faut-il s’inquiéter de la singularité ?

Les humains vivent confortablement en tant qu’êtres les plus intelligents de l’existence connue depuis des centaines de milliers d’années. Il est donc naturel que l’idée d’une super intelligence informatique nous mette un peu mal à l’aise. Mais quelles sont les principales préoccupations ici ?

Le plus grand risque perçu de la singularité serait la perte de contrôle de l’humanité sur la technologie super intelligente et donc de son destin.

Pouvons-nous empêcher la singularité ?

Les experts en IA sont divisés sur le sujet. Certains affirment que la singularité est inévitable, tandis que d’autres affirment que nous pouvons l’empêcher en réglementant soigneusement le développement de l’IA.

Alors que l’UE et le Royaume-Uni étudient la réglementation de l’IA, on craint qu’au moment où les réglementations sur l’IA seront adoptées, la singularité puisse déjà se produire. Et rien ne garantit qu’une réglementation significative puisse être adoptée.

Le potentiel d’amélioration de nombreux domaines grâce à l’IA, notamment la science, la médecine et l’éducation, est une perspective séduisante. Et nous n’avons même pas mentionné le côté corporatif de l’IA : il y a beaucoup d’argent à gagner. OpenAI a déclaré qu’elle pourrait quitter l’UE si les réglementations proposées actuellement sont adoptées. C’est un premier avant-goût de la résistance aux réglementations sur l’IA à laquelle nous pouvons nous attendre de la part de certaines des entreprises les plus puissantes du monde.

De plus, les gouvernements voudront se faire concurrence dans la sphère de l’IA. Même s’il existe un accord sur la menace potentielle de l’IA, aucun pays ne veut arrêter les progrès de peur de se laisser distancer par ses rivaux.

Il existe cependant d’autres moyens d’empêcher la singularité. L’un d’entre eux consisterait à mettre en place un interrupteur d’arrêt (physique ou programmé dans l’IA elle-même) pour mettre fin à l’IA si elle s’approche d’un état considéré comme une singularité. Cependant, la fin d’une IA par ailleurs utile n’est pas non plus une issue idéale. Dans un autre scénario, l’IA pourrait se rebeller, connaissant l’existence de l’interrupteur d’arrêt, et la pousser à atteindre la singularité.

Qu’est-ce qui rendrait la singularité possible ?

Le développement continu de l’intelligence artificielle est ce qui rendra la singularité possible. Si l’IA arrive au point où elle est capable d’inventer une technologie au-delà de notre compréhension et de nos capacités (IAG), on pourra dire sans risque que la singularité est arrivée – l’IA aura dépassé l’humanité en termes d’intelligence.

Et même si des restrictions sont mises en place dans la programmation d’une IA pour empêcher son intelligence de supplanter celle de l’humanité, de petites erreurs ou des paramètres mal définis pourraient par inadvertance provoquer la singularité que nous essayons d’empêcher.

Un comportement imprévu de l’IA a déjà été observé en raison de paramètres mal définis. En 2013, par exemple, le programmeur Tom Murphy a conçu une IA pour jouer à des jeux Nintendo NES. En jouant à Tetris, l’IA a appris à mettre le jeu en pause indéfiniment pour éviter de perdre. Murphy n’avait pas programmé l’IA pour cela. Imaginez les conséquences imprévues qui pourraient survenir avec une IA beaucoup plus puissante.

Conclusion

La singularité se présente comme la prochaine grande étape de l’évolution technologique. Il est fort probable que nous l’atteindrons un jour, mais de nombreux facteurs pourraient nous en empêcher. Le développement d’une conscience artificielle super intelligente capable de devancer les êtres humains nécessiterait des prouesses technologiques incroyablement avancées et complexes, dont nous ne sommes pas encore capables aujourd’hui. Mais avec l’évolution continue de la technologie, nous pourrions voir la singularité à l’horizon de notre vivant.

C’est pourquoi il est temps que nos gouvernements commencent à prendre au sérieux les questions d’éthique et de sécurité de l’IA. Ce n’est plus l’affaire des générations futures.